机器推理服务器是什么意思?有什么作用?

- 电脑知识

- 2025-04-15

- 3

- 更新:2025-04-08 19:47:12

引入:什么是机器推理服务器?

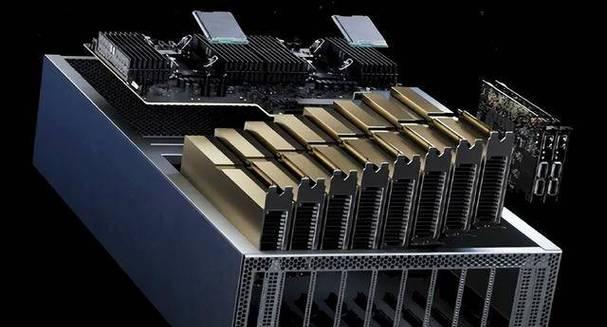

在当今这个数据爆炸的时代,机器学习与人工智能技术的迅猛发展,已经渗透到我们生活的方方面面。在这些技术的背后,一个重要的支撑点就是机器推理服务器。机器推理服务器是一种专门设计用来处理大量数据、执行复杂算法,并完成机器学习任务的高性能计算系统。它通常搭载了先进的硬件和优化后的软件,能够支持各种推理任务,如图像识别、语音理解、自然语言处理等。

机器推理服务器的核心组件

硬件组成

GPU:图形处理器(GPU)由于其并行计算能力,非常适合执行大规模矩阵运算,是目前机器学习和深度学习计算的首选。

TPU:张量处理器(TPU)是谷歌开发的专门为深度学习优化的芯片,提供了比传统GPU更快的机器学习推理速度。

FPGA:现场可编程门阵列(FPGA)提供了高度的自定义性和灵活性,允许对特定算法进行硬件加速。

软件组成

操作系统:Linux是机器推理服务器中最常使用的操作系统,因为它稳定且对高性能计算友好。

深度学习框架:TensorFlow、PyTorch等深度学习框架为机器学习模型的部署提供了基础。

优化算法:针对特定硬件的优化算法可以显著提升推理性能,例如模型压缩、量化技术等。

机器推理服务器的作用

推理与预测

机器推理服务器能够接收输入数据,并通过训练好的模型快速做出推理和预测。在如自动驾驶、医疗影像分析、金融风险评估等领域,推理服务器的快速响应至关重要。

大规模部署

对于需要在大规模数据集上运行模型的应用,机器推理服务器提供了所需的计算资源。通过分布式计算,它可以同时处理数以千计的用户请求,保证服务的高效和稳定。

模型优化

机器推理服务器不仅执行推理,还可以进行模型的优化。通过对模型进行剪枝、量化等操作,可以减小模型体积,降低计算资源消耗,同时保持较高的准确率。

机器推理服务器的挑战与未来

能耗问题

随着机器学习模型的日益复杂,推理服务器的能耗问题越来越突出。寻找更高效的硬件和算法优化方法,以降低能耗是目前研究的热点。

安全性

推理过程中的数据隐私和模型安全同样重要。如何在保证推理性能的同时,加强数据加密和访问控制,防止数据泄露和模型被攻击,是未来发展中需要解决的问题。

可扩展性

随着技术的进步和应用需求的增长,机器推理服务器需要具备良好的可扩展性。能够根据计算需求的增减,灵活调整资源分配,是未来服务器设计的重要方向。

结语

综合以上,机器推理服务器是现代人工智能技术中的核心部件,它通过高效的计算能力支持着复杂算法的执行,是许多高科技应用背后的强大动力。随着技术的不断进步和优化,我们可以期待机器推理服务器在未来将在更多领域发挥重要作用,为人类生活带来便利。